Omdia在其发布的最新报告中指出,随着推理开始取得进展,Omdia预计到2028年,推理存储将以近20%的年复合增长率增长,几乎是用于LLM训练存储的四倍。

图源:网络

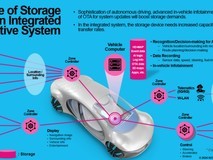

什么样的存储适合大模型推理?Omdia在报告中指出,对于模型推理和部署,NVMe(非易失性存储器高速)驱动器等低延迟存储可提供快速数据检索并提高实时性能。

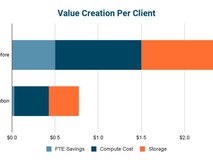

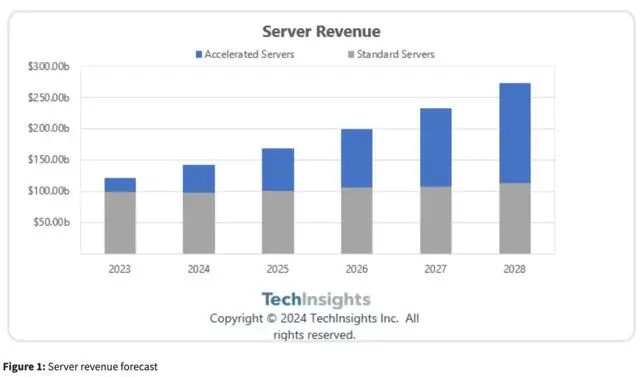

在大模型发展的当下,AI服务器也开始稳健增长,TechInsights预测,到2028年,服务器市场规模将达到2730亿美元,年复合增长率为18%。

分析认为,近年来,服务器需求本质上是周期性的,受更新周期的起伏影响。而现在,一种颠覆性的影响正在刺激增长,那就是人工智能。

同时,TechInsights预计到2028年,专为AI应用设计的服务器将占市场份额的59%,复合年增长率为49%。

图源:TechInsights

这些服务器通常包含更多高性能处理器内核、内存、存储和网卡,以处理复杂的AI应用。TechInsights认为,标准服务器的年均复合增长率为 3%,而不是像某些业内人士所说的那样出现下滑。

另外,随着大模型技术日趋成熟,大模型于应用层的探索与应用,大模型推理需求将持续增长,这也使得推理存储的发展。

本文属于原创文章,如若转载,请注明来源:模型推理取得进展,推理存储年复合增长率将达20%https://stor.zol.com.cn/883/8834214.html